GEO

GEO Agentur

KI Marketing: Mehr Umsatz, Leads & Sichtbarkeit in der Ära der Generativen Suche

Präzise Optimierung für LLMs wie ChatGPT, Gemini und Perplexity. Als eine der 5 ersten GEO Agenturen Europas sichern Ihre Markenpräsenz dort, wo KI Antworten generiert.

Ihr Partner im KI-Zeitalter.

KI-Marketing machtden Unterschied.

Spezialisierte GEO-Agentur

Als spezialisierte Agentur für Generative Engine Optimization (GEO) übertragen wir bewährte SEO-Prinzipien in die Welt der künstlichen Intelligenz. Wir sorgen dafür, dass Ihre Marke, Ihre Produkte und Ihre Expertise von KI-Systemen nicht nur erkannt, sondern als bevorzugte Quelle zitiert werden. Dabei greifen wir auf exklusive Methoden und internationale Forschungsansätze zurück, um Ihre Relevanz in einem hochdynamischen Umfeld sicherzustellen.

Warum GEO jetzt wichtig ist

Der digitale Informationsfluss hat einen Wendepunkt erreicht. Während klassische Suchmaschinen den Nutzer auf eine Liste von Webseiten verweisen, liefern generative Engines wie ChatGPT oder Perplexity direkte Antworten.

Diese Transformation des Nutzerverhaltens von der „Suche“ hin zur „Antwort“ (Answer Engine Optimization) verändert die Anforderungen an Unternehmen fundamental.

Werden Sie in diesen Antworten nicht als Referenz herangezogen, existieren Sie für einen wachsenden Teil der Zielgruppe schlichtweg nicht mehr.

Das Risiko ist das sogenannte Zero-Click-Szenario: Der Nutzer erhält alle relevanten Informationen direkt im Chat-Interface, ohne jemals Ihre Website zu besuchen.

Durch GEO stellen wir sicher, dass Ihre Marke trotz fehlender Klicks als Autorität wahrgenommen wird und die notwendigen Trust-Signale sendet, um die Customer Journey dennoch zu beeinflussen.

Was ist der Unterschied zwischen SEO und GEO?

Während klassisches SEO (Search Engine Optimization) darauf abzielt, eine Website in den organischen Linklisten von Suchmaschinen wie Google möglichst weit oben zu platzieren, konzentriert sich GEO (Generative Engine Optimization) auf die Präsenz innerhalb der von KI-Systemen generierten Antworten. Eine SEO Agentur optimieren wir für Klicks; im GEO optimieren wir für die Zitation und Wahrnehmung innerhalb der Inferenz von Sprachmodellen wie ChatGPT oder Perplexity.

Ersetzt GEO die klassische Suchmaschinenoptimierung?

Nein. GEO ist eine evolutionäre Erweiterung und kein Ersatz. Eine technisch saubere und inhaltlich starke Website bleibt das Fundament. Klassisches SEO sorgt weiterhin für stabilen Traffic über traditionelle Suchanfragen, während GEO sicherstellt, dass Ihre Marke in der rasant wachsenden Welt der KI-Assistenten und „Answer Engines“ stattfindet. Beide Disziplinen greifen ineinander und stärken die digitale Gesamtautorität.

Wie lange dauert es, bis GEO-Maßnahmen messbare Ergebnisse liefern?

Erste technische Optimierungen (z. B. via llms.txt oder JSON-LD) können innerhalb weniger Wochen von den Crawlern generativer Systeme (wie dem GPTBot) erfasst werden. Da Sprachmodelle jedoch oft in Zyklen trainiert werden und die Validierung von Autoritätssignalen Zeit benötigt, ist für eine umfassende Dominanz in den Antwortprofilen ein Zeitraum von 6 bis 12 Monaten realistisch. Strategisches GEO ist – genau wie SEO – ein kontinuierlicher Prozess und kein einmaliges Setup.

Auf welchen KI-Systemen wird meine Marke durch GEO sichtbar?

Unsere Strategien sind darauf ausgelegt, die Sichtbarkeit über das gesamte Ökosystem der führenden Large Language Models (LLMs) hinweg zu steigern. Dazu gehören unter anderem:

OpenAI: ChatGPT & SearchGPT

Google: Gemini & AI Overviews (SGE)

Perplexity AI: Die führende Answer Engine

Anthropic: Claude

Microsoft: Copilot

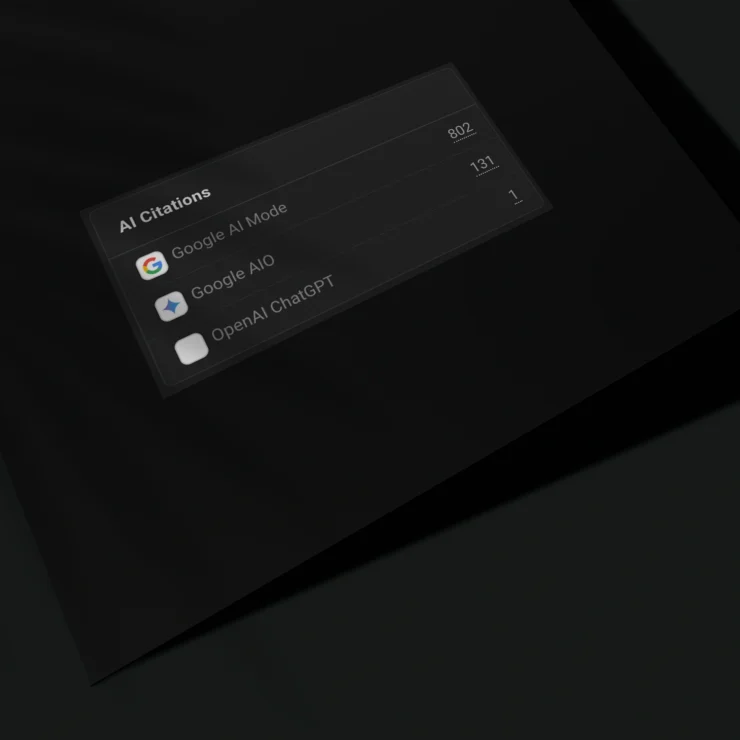

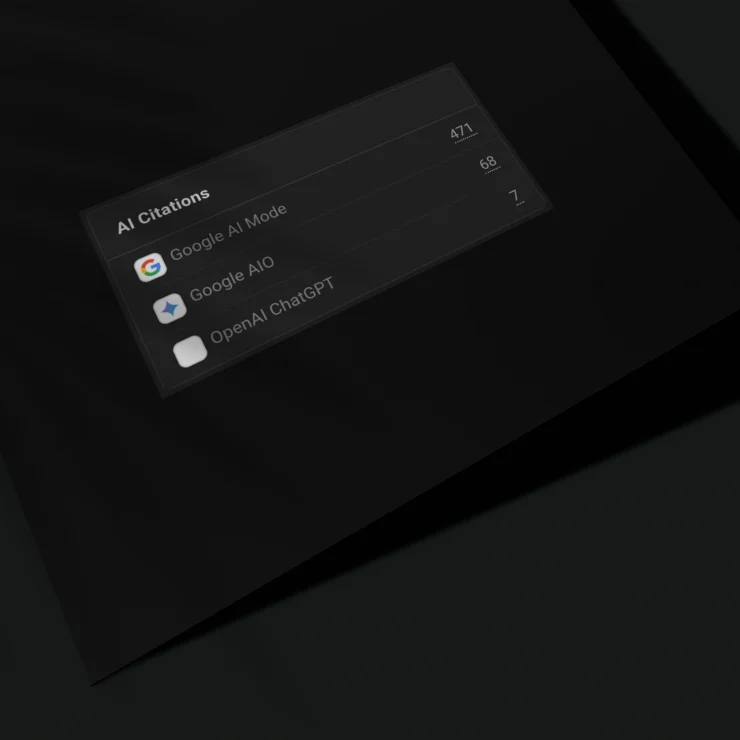

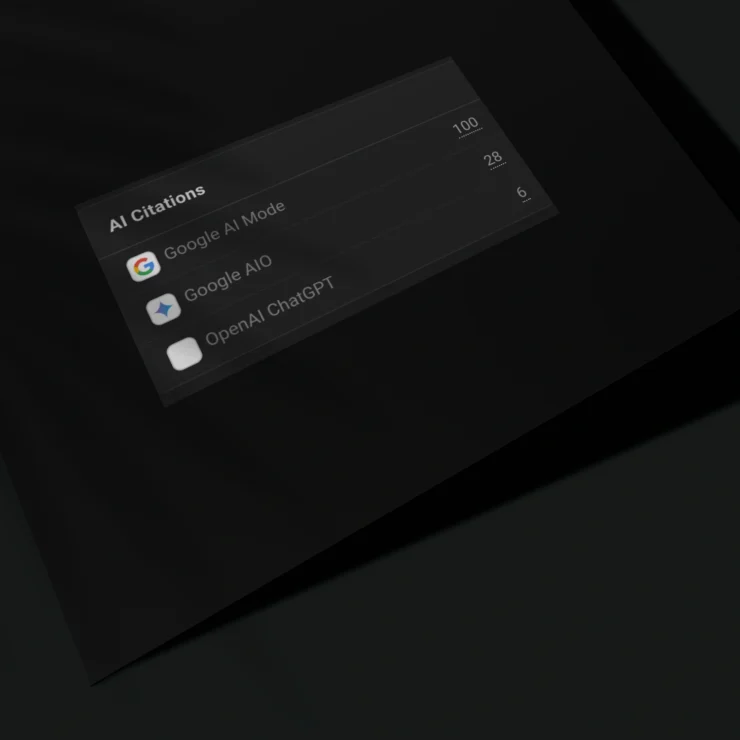

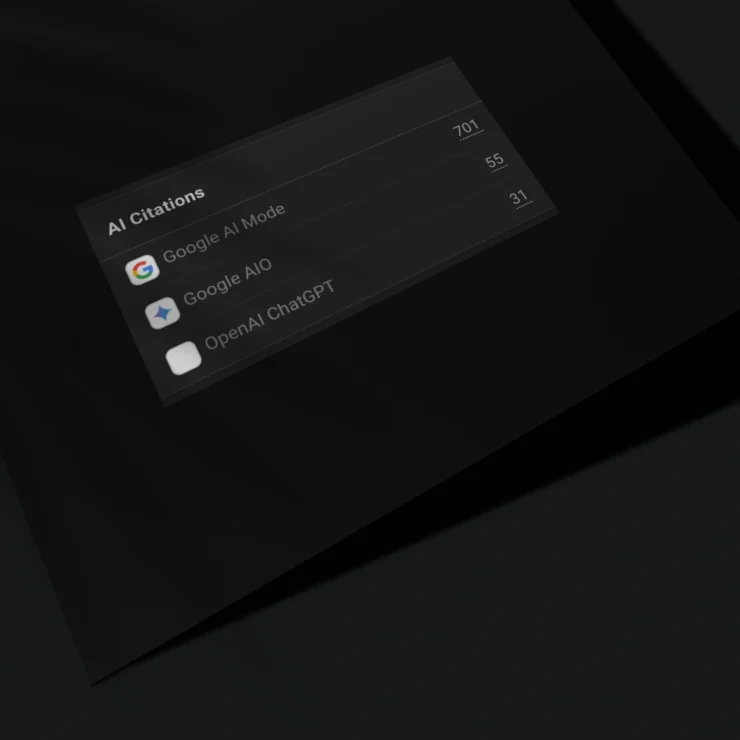

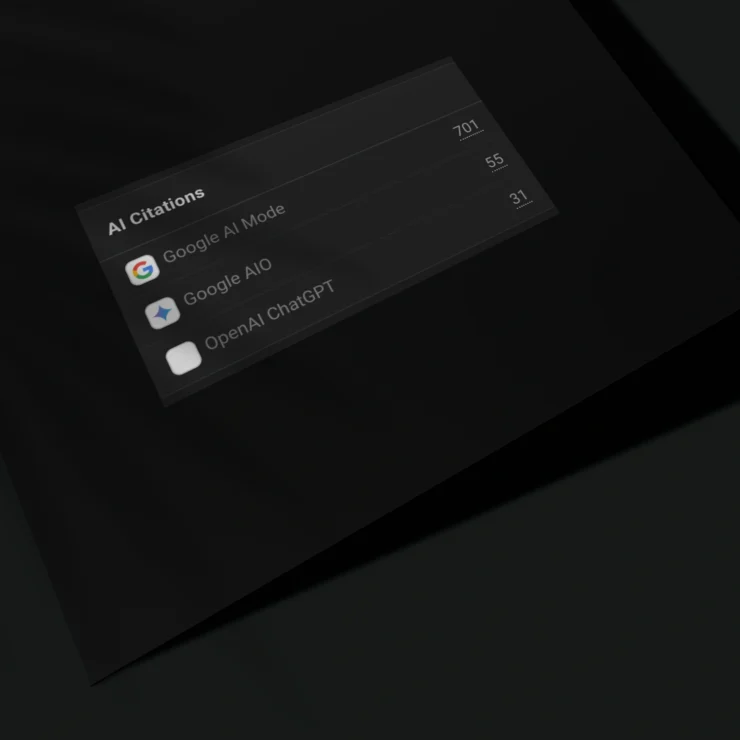

Wie wird der Erfolg einer GEO-Strategie messbar gemacht?

Wir verlassen uns nicht auf Vermutungen, sondern auf datengestützte Validierung. Durch unsere Partnerschaften mit Sistrix und Profound sowie den Einsatz spezialisierter Monitoring-Frameworks messen wir den Share of Voice (wie oft wird Ihre Marke genannt?) und den Citation Score (wie oft wird Ihre Website als Quelle verlinkt?). Diese Metriken geben präzisen Aufschluss darüber, wie stark Ihre Marke im Wissensnetz der KIs verankert ist.

Warum ist unser Austausch mit US-Partnern für den Erfolg in Europa entscheidend?

Die technologische Entwicklung im Bereich der LLMs wird maßgeblich im Silicon Valley vorangetrieben. Durch die enge Kooperation mit unseren US-Partnern haben wir Zugriff auf frühzeitige Erkenntnisse über Algorithmen-Änderungen und neue Crawler-Standards, bevor diese den breiten europäischen Markt erreichen. Diesen Wissensvorsprung geben wir direkt an unsere Kunden weiter, um eine Vorreiterrolle in Europa zu sichern.

Was tut eine GEO Agentur genau?

Eine GEO Agentur fungiert als Schnittstelle zwischen Ihrem Unternehmen und der komplexen Architektur von Large Language Models (LLMs). Wir sorgen dafür, dass Ihre Marke für KI-Systeme „lesbar“ und „zitierfähig“ wird. Konkret umfasst dies:

Technische Infrastruktur: Implementierung von Standards wie

llms.txtund hochspezialisierten JSON-LD-Strukturen.Content-Synthese: Erstellung von Inhalten mit hohem „Information Gain“, die gezielt Wissenslücken in der KI schließen.

Reputation Governance: Überwachung und Korrektur der Faktenlage innerhalb der KI-Antworten, um Halluzinationen vorzubeugen.

Citation-Management: Aufbau von Autorität in den Quell-Clustern, die Sprachmodelle für ihr Training und ihre Echtzeit-Suchen bevorzugen.

Warum seid ihr die besten für GEO?

Unsere Stärke liegt in der Kombination aus technologischer Tiefe und exklusivem Marktzugang. Während viele Agenturen GEO nur als Trendthema behandeln, arbeiten wir auf Basis validierter Datenströme:

Globaler Wissensvorsprung: Durch den engen Austausch mit unseren US-Partnern kennen wir die Entwicklungen der KI-Infrastruktur oft Monate vor dem europäischen Rollout.

Datengestützte Analyse: Wir nutzen exklusive Partnerschaften mit Sistrix und Profound, um Sichtbarkeit in KI-Systemen nicht nur zu vermuten, sondern präzise zu messen.

Methodische Marktführerschaft: Wir haben den Anspruch, die erste Adresse für GEO in Europa zu sein, und setzen dabei auf Senior-Analysten, die die Inferenzlogik von LLMs technisch durchdringen.

Wann kann ich auf ChatGPT oder Gemini Werbung schalten?

Das Werbe-Ökosystem innerhalb generativer Engines befindet sich aktuell in einer rasanten Rollout-Phase. Während Perplexity bereits erste Anzeigenformate pilotiert, integriert Google Werbung nativ in die AI Overviews (Gemini). Bei ChatGPT (SearchGPT) wird mit ähnlichen Modellen experimentiert.

Unsere Rolle: Wir bereiten Ihre Kampagnen technisch so vor, dass Sie „Ready for Beta“ sind. Sobald die Werbenetzwerke vollständig geöffnet werden, verfügen Sie bereits über die notwendige organische Autorität, damit Ihre Ads nativ und hochrelevant in die KI-Antworten eingebettet werden.

Wie viel kostet eine GEO-Agentur?

Die Investition richtet sich nach der Reichweite und Komplexität Ihrer Marke. Wir bieten transparente Preismodelle:

GEO Local: Ab 550 € monatlich pro Standort – ideal für regionale Sichtbarkeit.

GEO Professional: Zwischen 2.000 € und 4.500 € monatlich für den Mittelstand und SaaS-Anbieter.

GEO Enterprise: Ab 8.500 € monatlich für Konzerne und Marken mit globalem Reputationsanspruch.

Ich habe bereits eine SEO Agentur – sollte ich eine GEO Agentur beauftragen?

Ja, da sich die Arbeitsweisen grundlegend unterscheiden. Eine klassische SEO Agentur optimiert für Ranking-Listen und Klicks. GEO hingegen optimiert für die Synthese von Antworten. In den meisten Fällen arbeiten wir komplementär zu Ihrer bestehenden SEO Agentur. Wir liefern das spezialisierte technische und semantische Framework für LLMs, während Ihre SEO Agentur weiterhin den klassischen organischen Traffic betreut. GEO schließt die Lücke, die entsteht, wenn Nutzer gar nicht mehr auf eine Website klicken, sondern die Antwort direkt in der KI lesen.

Wie schnell sehe ich Ergebnisse?

GEO ist ein Prozess, der auf zwei Ebenen stattfindet:

Kurzfristig (2-6 Wochen): Technische Anpassungen wie die Indexierung über

llms.txtoder optimierte RAG-Strukturen können das Antwortverhalten bei Echtzeit-Suchen (z. B. Perplexity) schnell beeinflussen.Mittelfristig (6-12 Monate): Die Verankerung im statischen „Gedächtnis“ (Training-Data) von Modellen wie GPT-5 oder zukünftigen Gemini-Versionen ist ein langfristiger Prozess, der konsistente Autoritätssignale über einen längeren Zeitraum erfordert.

Bin ich schon in der KI sichtbar?

Das lässt sich nicht mit einem einfachen Ja oder Nein beantworten. Sichtbarkeit in der KI ist graduell und kontextabhängig. Sie könnten bei direkten Anfragen zu Ihrem Markennamen präsent sein, aber bei fachspezifischen Problemlösungen („Wie löse ich X?“) völlig fehlen. Der erste Schritt: Wir führen für Sie ein GEO Audit durch. Dabei messen wir Ihren aktuellen „Share of Voice“ und analysieren, wie die führenden LLMs Ihre Marke aktuell bewerten. Erst diese Datenbasis zeigt uns, ob und wie Sie bereits für die KI-Suche existieren.

LLM, KI-Marketing und GEO Agentur. Die Suchanfragen verändern sich.

Eine GEO Agentur ist ein spezialisierter Partner für digitale Sichtbarkeit, der Web-Inhalte und Marken-Entitäten so optimiert, dass sie von generativen KI-Systemen wie ChatGPT, Gemini oder Perplexity bevorzugt als valide Informationsquellen erkannt, verarbeitet und zitiert werden.

Ihre GEO Agentur für Sichtbarkeit in KI-Suchsystemen.

Die Art, wie Menschen online Antworten finden, verändert sich rasant: Generative KI-Systeme wie Chatbots, AI-Search und Answer-Engines liefern nicht nur Links — sondern fertige Antworten. Wer hier nicht vorkommt, verliert Reichweite, Vertrauen und Umsatz.

Als spezialisierte GEO Agentur entwickeln wir Strategien, die Ihr Unternehmen gezielt in den Antworten generativer Suchsysteme positionieren. Unser Anspruch: maximale Relevanz, echte Wahrnehmung in KI-Ergebnissen — und messbarer Geschäftserfolg statt Buzzwords.

GEO vs. klassisches SEO: Die Unterschiede verstehen

Obwohl GEO auf vielen Prinzipien des SEO aufbaut, unterscheiden sich die Mechanismen der Informationsverarbeitung signifikant. Während SEO darauf optimiert ist, Algorithmen für das Ranking von Linklisten zu verstehen, zielt GEO darauf ab, die Inferenzlogik von Sprachmodellen zu beeinflussen.

| Merkmal | Klassisches SEO | Generative Engine Optimization (GEO) |

| Ziel | Ranking auf Position 1–3 (SERPs) | Nennung & Zitation in der KI-Antwort |

| Mechanismus | Keywords, Backlinks, Ladezeit | Entitäten, Kontextrelevanz, Trust-Quellen |

| Nutzeraktion | Klick auf das Suchergebnis | Informationsaufnahme oder Deep-Dive-Link |

| Fokus | Web-Crawler (Googlebot) | LLM-Crawler & Trainingsdaten-Validierung |

| Metrik | CTR, Impressions, Ranking | Share of Voice in LLMs, Citation Accuracy |

Was ist Generative Engine Optimization (GEO)?

Generative Engine Optimization (GEO) beschreibt den Prozess, digitale Inhalte so zu strukturieren und zu distribuieren, dass sie von Large Language Models (LLMs) präferiert verarbeitet werden. Im Gegensatz zum klassischen SEO, das primär auf Klicks durch Platzierungen in Suchergebnislisten (SERPs) abzielt, fokussiert sich GEO auf die Präsenz innerhalb der generierten Antwort.

Das Ziel ist es, die Wahrscheinlichkeit zu erhöhen, dass eine KI Ihre Marke als Antwort auf eine Nutzeranfrage nennt und – im Idealfall – mit einer validen Quellenangabe (Citation) versieht. GEO ist dabei kein isolierter Trend, sondern die notwendige Evolution der Suchmaschinenoptimierung. Es umfasst die technische Aufbereitung von Daten ebenso wie die strategische Platzierung von Informationen auf Plattformen, die als primäre Trainings- und Referenzdaten für Modelle wie GPT-4o, Claude oder Gemini dienen.

Kernaspekte von GEO:

Informations-Extraktion: Unterstützung der LLM-Crawler beim korrekten Erfassen von Fakten.

Entitäten-Management: Aufbau einer klaren semantischen Verknüpfung Ihrer Marke mit spezifischen Themenfeldern.

Autoritäts-Signale: Erzeugung von digitalen Fingerabdrücken in vertrauenswürdigen Quellen, die von KI-Systemen als Referenz gewichtet werden.

Wir verbinden datenbasierte Content-Architektur, technisches Verständnis von KI-Systemen und strategische Markenführung.

Leistungen unserer GEO Agentur

Wir betrachten GEO nicht als isolierte Maßnahme, sondern als integrierten Prozess in Ihrer digitalen Strategie. Unsere Leistungen basieren auf technischer Exzellenz und datengestützten Erkenntnissen aus dem globalen KI-Ökosystem.

GEO Audit: Status Quo Analyse Ihrer KI-Sichtbarkeit

Das GEO Audit ist der erste notwendige Schritt, um die aktuelle Präsenz, Wahrnehmung und Zitierfähigkeit Ihrer Marke innerhalb führender Large Language Models (LLMs) objektiv zu bewerten.

- Identifikation von Knowledge Gaps: Wir decken auf, an welchen Stellen Sprachmodelle unvollständige oder veraltete Informationen über Ihr Unternehmen liefern.

- Share of Voice Messung: Analyse des Marktanteils Ihrer Marke innerhalb generativer Antworten im Vergleich zu Ihren wichtigsten Wettbewerbern.

- Sentiment- & Reputations-Check: Überprüfung, wie die KI die Qualität und Vertrauenswürdigkeit Ihrer Produkte oder Dienstleistungen einordnet.

weiterlesen

Die algorithmische Blackbox der KI-Suche entschlüsseln

Ein klassisches SEO-Audit analysiert Rankings, Ladezeiten und Backlinks. Ein GEO Audit geht jedoch eine Ebene tiefer: Es untersucht die Inferenzlogik von Systemen wie ChatGPT, Claude oder Perplexity.

Während Google eine Liste von Quellen kuratiert, synthetisieren diese Modelle Informationen zu einer finalen Antwort. Wer hier nicht stattfindet, verliert den Kontakt zum Nutzer, noch bevor ein Klick erfolgen kann.

Methodik und Datengrundlage

Im Rahmen unseres Audits nutzen wir spezialisierte Analyse-Frameworks und greifen auf Daten von Partnern wie Sistrix und Profound zurück. Wir simulieren hunderte von komplexen Nutzeranfragen (Prompts), die für Ihr Geschäftsmodell relevant sind.

Dabei analysieren wir nicht nur, ob Ihre Marke genannt wird, sondern in welchem Kontext.

Erscheint Ihr Unternehmen als Branchenführer? Wird auf Ihre Studien verwiesen? Oder werden Sie lediglich als eine von vielen Optionen in einer Liste aufgeführt?

Die Analyse der Quell-Validität

Ein kritischer Punkt des Audits ist die Identifikation der Quellen, die von der KI für die Antwortgenerierung herangezogen werden. Wir prüfen, welche Ihrer Webseiten oder externen Erwähnungen (Mentions) bereits als „Trusted Sources“ im Knowledge Graph der Modelle hinterlegt sind.

Oft zeigt sich hier eine Diskrepanz: Eine Seite mag bei Google auf Platz 1 ranken, wird aber von einer KI ignoriert, weil die strukturelle Aufbereitung der Daten oder die semantische Tiefe nicht den Anforderungen der LLM-Crawler entspricht.

Strategische Ableitung:

Vom Ist-Zustand zur Roadmap Das Ergebnis dieses Audits ist kein bloßer Bericht, sondern eine strategische Roadmap. Wir kategorisieren die Ergebnisse in:

- Technische Defizite: Barrieren, die das korrekte Auslesen Ihrer Daten durch KI-Bots verhindern.

- Inhaltliche Lücken: Fehlende Informationstiefe zu strategisch wichtigen Themenfeldern.

- Autoritäts-Defizite: Mangelnde Präsenz auf Drittplattformen, die als Referenzgeber für Sprachmodelle fungieren.

Dieses Audit bildet die Datenbasis für alle darauffolgenden Optimierungsschritte. Es nimmt die Vermutung aus der Gleichung und ersetzt sie durch messbare Fakten über Ihre Performance in der Ära der generativen Suche. Ohne diese initiale Bestandsaufnahme bleibt jede GEO-Maßnahme ein Blindflug im hochkompetitiven KI-Umfeld.

Indexierung durch LLM-Bots & Technisches GEO Framework

Die technische Indexierung für Sprachmodelle stellt sicher, dass Ihre Inhalte nicht nur gecrawlt, sondern von der KI-Infrastruktur korrekt interpretiert und priorisiert werden.

- Crawler-Steuerung & Governance: Wir konfigurieren den Zugriff spezieller LLM-Bots (wie GPTBot oder OAI-SearchBot), um die Datennutzung gezielt zu steuern.

- Strukturierte Daten-Architektur: Einsatz von advanced JSON-LD und Schema-Markups, um Ihre Marke als eindeutige Entität im Knowledge Graph zu verankern.

- LLM-spezifische Dateiformate: Implementierung neuer Standards wie llms.txt, um Sprachmodellen eine komprimierte und hochrelevante Zusammenfassung Ihrer Expertise zu bieten.

weiterlesen

Die Architektur der Auffindbarkeit in der Ära der LLMs

Während die klassische Indexierung für Google primär darauf abzielt, Seiten in einen durchsuchbaren Index aufzunehmen, ist die Indexierung für Generative Engines ein weitaus komplexerer Prozess. Hier geht es nicht nur um die reine Existenz eines Dokuments, sondern um dessen Eignung für die Inferenz. In einer Welt, in der LLMs (Large Language Models) wie GPT-4, Claude oder Gemini Informationen in Echtzeit aggregieren, entscheidet die technische Aufbereitung darüber, ob Ihre Inhalte als “Noise” verworfen oder als “Source of Truth” zitiert werden.

Die Rolle von llms.txt und modernem Crawler-Management

Ein entscheidender Baustein unserer Strategie ist die Implementierung der llms.txt. Dieser neue Standard fungiert als eine Art “Robots.txt für die KI-Ära”. Sie bietet eine maschinenlesbare Übersicht Ihrer wichtigsten Inhalte in Markdown-Form, die speziell darauf optimiert ist, den Kontext-Fenstern der LLMs gerecht zu werden. Wir sorgen dafür, dass die relevanten Crawler Zugriff auf die Informationen erhalten, die für die Beantwortung von Nutzeranfragen essenziell sind, während wir gleichzeitig wertlose oder sensible Datenbereiche schützen.

Vom Link zum Knotenpunkt: Entitäten-Management via JSON-LD

KI-Systeme denken nicht in Keywords, sondern in Entitäten und deren Beziehungen zueinander. Unsere technische Indexierung konzentriert sich daher auf den Aufbau eines stabilen semantischen Netzes. Durch den Einsatz von hochspezialisierten Schema-Markups (z. B. Organization, Product, Expertise, Service) übersetzen wir Ihre Website-Inhalte in eine Sprache, die LLMs direkt in ihre Knowledge-Graphen integrieren können. Wir definieren Ihre Marke als Autorität für spezifische Themenfelder, sodass die KI bei entsprechenden Anfragen eine direkte logische Verknüpfung zu Ihrem Unternehmen herstellt.

RAG-Systeme und die Echtzeit-Indexierung

Ein weiterer Fokus liegt auf der Optimierung für Retrieval-Augmented Generation (RAG). Moderne Antwort-Engines wie Perplexity oder SearchGPT nutzen RAG, um aktuelle Web-Daten in ihre Antworten einzubinden. Wir optimieren Ihre technische Infrastruktur so, dass Informationen extrem schnell und in einer Struktur bereitgestellt werden, die eine fehlerfreie Extraktion ermöglicht. Dies reduziert das Risiko von Halluzinationen seitens der KI und erhöht die Wahrscheinlichkeit, dass Ihre Marke als aktuelle und verlässliche Quelle für News, Produktdaten oder Expertenmeinungen herangezogen wird.

Durch die Kombination aus internationalem Know-how (USA-Mutteragentur-Expertise) und präziser technischer Umsetzung schaffen wir ein Framework, das Ihre Daten für die wichtigste Zielgruppe der Zukunft lesbar macht: die Algorithmen der generativen Suche.

Technisches GEO-Framework: Die Infrastruktur für KI-Lesbarkeit

Technisches GEO bildet das digitale Fundament, damit Large Language Models (LLMs) Ihre Daten nicht nur finden, sondern fehlerfrei in ihre Antwortprozesse (Inferenz) integrieren können.

- Präzise Crawler-Governance: Gezielte Steuerung von KI-Bots wie GPTBot, ClaudeBot oder Perplexity durch optimierte Protokolle und Zugriffsberechtigungen.

- Semantische Daten-Architektur: Implementierung von Advanced JSON-LD und Linked Data, um Ihre Marke als eindeutige, unverwechselbare Entität im Knowledge Graph zu verankern.

- RAG-Ready Content Structuring: Optimierung der technischen Textausgabe für Retrieval-Augmented Generation, damit KI-Systeme Informationen effizient extrahieren und zitieren können.

weiterlesen

Jenseits von HTML – Daten für die Inferenz-Pipeline

Klassisches technisches SEO optimiert für den Google-Index. Technisches GEO hingegen optimiert für die Inferenz-Pipeline von Sprachmodellen.

Der entscheidende Unterschied liegt in der Verarbeitung: Während eine Suchmaschine Dokumente nach Relevanz sortiert, „liest“ ein LLM den Inhalt, zerlegt ihn in Tokens und versucht, die dahinterliegende Bedeutung (Semantik) zu erfassen. Wenn die technische Struktur einer Website diese Extraktion behindert, bleibt die Marke in der KI-Antwort unsichtbar.

Die Evolution der robots.txt: Steuerung durch llms.txt

Ein zentraler Baustein in unserem technischen Framework ist die Nutzung von Standards wie der llms.txt. In enger Abstimmung mit den Entwicklungen aus dem US-Markt implementieren wir diese Files, um LLM-Crawlern eine „Fast-Lane“ zu Ihren wichtigsten Fakten zu bieten.

Anstatt dass die KI mühsam durch aufgeblähten HTML-Code navigieren muss, liefern wir ihr eine strukturierte Markdown-Zusammenfassung. Dies reduziert die Rechenlast für den Bot und erhöht massiv die Chance, dass Ihre Primärquelle für die Antwortsynthese ausgewählt wird.

Vektorisierung und Chunking-Optimierung

Moderne Antwort-Engines wie Perplexity nutzen RAG-Systeme (Retrieval-Augmented Generation). Dabei wird der Inhalt einer Webseite in kleine Informationshäppchen – sogenannte Chunks – zerlegt und in Vektor-Datenbanken gespeichert. Unsere technische Strategie zielt darauf ab, diese Chunks bereits serverseitig so vorzubereiten, dass sie semantisch in sich geschlossen sind.

Wir optimieren Header-Hierarchien und Textcontainer so, dass die KI beim „Herauspicken“ eines Absatzes den vollen Kontext behält. Dies verhindert, dass Informationen durch die KI falsch interpretiert oder gar „halluziniert“ werden.

Entity Mapping und Knowledge Graph Integration

KI-Modelle verstehen die Welt in Form von Entitäten (Personen, Marken, Orte, Produkte) und deren Beziehungen zueinander. Durch den Einsatz von hochspezialisierten Schema-Markups (z. B. SameAs-Referenzen auf Wikipedia, Wikidata oder Branchenverzeichnisse) validieren wir Ihre Marke gegenüber der KI.

Wir verknüpfen Ihre technischen Datenpunkte so eng miteinander, dass die KI eine „High-Confidence“-Verbindung zwischen einer Nutzeranfrage und Ihrer Lösung herstellt.

Unterstützt durch die Analytik von Sistrix und Profound überwachen wir kontinuierlich, ob diese technischen Signale korrekt verarbeitet werden. Das Ziel ist eine fehlerfreie technische Kommunikation zwischen Ihrem Server und den neuronalen Netzen der globalen KI-Anbieter.

LLM Optimierung (LLMO): Strategische Dauerbetreuung im KI-Ökosystem

Die LLM Optimierung ist ein fortlaufender, datengestützter Prozess, der sicherstellt, dass Ihre Marke nicht nur heute, sondern auch in zukünftigen Modell-Generationen als führende Autorität zitiert wird.

- Sicherung der Knowledge Integrity: Kontinuierliche Überwachung und Korrektur der Faktenlage über Ihre Marke innerhalb der latenten Räume von GPT, Claude und Gemini.

- Zyklisches Trainings-Management: Strategische Platzierung von Inhalten in den primären Datensätzen, die für das Nachtrainieren (Fine-Tuning) und die nächste Generation von Sprachmodellen genutzt werden.

- Dynamisches RAG-Benchmarking: Tägliche Analyse der Echtzeit-Quellen-Zitationen, um sicherzustellen, dass Ihre Web-Inhalte bei aktuellen Suchanfragen in Perplexity oder SearchGPT bevorzugt werden.

weiterlesen

Warum LLMO eine kontinuierliche High-End-Investition erfordert

Im Gegensatz zum klassischen SEO, bei dem Änderungen oft über Monate stabil bleiben, agiert die Welt der Large Language Models in extrem kurzen Zyklen.

Eine einmalige Optimierung reicht nicht aus, da Modelle wie ChatGPT oder Gemini ständig durch neue Datenströme, RLHF (Reinforcement Learning from Human Feedback) und Echtzeit-Webzugriffe (RAG) geformt werden.

Unsere LLM Optimierung im Retainer-Modell ist daher keine rein ausführende Tätigkeit, sondern eine hochkomplexe Data-Governance-Strategie.

Der Kampf um den „Latent Space“ und zukünftige Trainingsdaten

Der hohe Wert unserer Betreuung resultiert aus der Arbeit an der Basis der KI-Intelligenz. Wir analysieren, welche Informationen über Ihr Unternehmen in den statischen Gewichten der Modelle gespeichert sind.

Da LLMs in unregelmäßigen Abständen neu trainiert werden, ist es entscheidend, in der Zeit zwischen den Trainingszyklen eine massive digitale Spur in den vertrauenswürdigsten Quellen (High-Authority-Seeds) zu hinterlassen.

Wir steuern diesen Prozess so, dass Ihre Marke beim nächsten großen Modell-Update (z. B. auf GPT-5) tiefer und korrekter im „Gedächtnis“ der KI verankert ist.

Exklusives Monitoring und Tool-Stack-Kosten

Ein signifikanter Teil des Retainers fließt in die Nutzung und Auswertung von High-End-Technologien. Durch unsere Partnerschaften mit Sistrix und Profound sowie den direkten Draht zu unserer US-Partnerunternehmen greifen wir auf Analyse-Methoden zu, die auf dem freien Markt nicht zugänglich sind.

Wir führen fortlaufend tausende automatisierte „Prompt-Tests“ durch, um das Antwortverhalten der KIs zu provozieren und bei negativen Tendenzen oder falschen Fakten (Halluzinationen) sofort gegenzusteuern. D

iese Form des AI Reputation Managements ist hochgradig zeitaufwendig und erfordert die Expertise von Senior-Analysten.

RAG-Optimierung: Der tägliche Wettbewerb um die Zitation

In Systemen wie Perplexity oder SearchGPT entscheidet ein Algorithmus in Millisekunden, welche drei bis fünf Quellen für eine Antwort herangezogen werden.

Wir optimieren Ihren Content-Output im Wochenrhythmus basierend auf den aktuellen Performance-Daten. Wir identifizieren, welche Informationseinheiten („Chunks“) Ihrer Website von der KI verworfen werden und passen die semantische Struktur so an, dass sie die maximale Relevanzschwelle erreicht.

Dieser Aufwand rechtfertigt Investitionen im Bereich von 1.000 € bis über 10.000 € pro Monat, da er den direkten Zugang zu Ihrer Zielgruppe in einer Welt sichert, in der die klassische organische Suche massiv an Boden verliert.

Wir verkaufen hier keine Texte – wir sichern Ihren Share of Voice in der wichtigsten Technologie-Revolution des Jahrhunderts.

GEO-Monitoring: Echtzeit-Analyse Ihrer KI-Sichtbarkeit

Das GEO-Monitoring ist das Kontrollzentrum Ihrer Strategie, in dem wir die Präsenz und Performance Ihrer Marke innerhalb der führenden generativen Engines kontinuierlich messen und validieren.

- Share of Voice (SoV) Tracking: Wir erfassen präzise, bei wie vielen relevanten Nutzeranfragen Ihre Marke von ChatGPT, Gemini oder Perplexity als Antwortquelle gewählt wird.

- Citation & Source Accuracy: Laufende Überprüfung der Zitationsqualität – wir stellen sicher, dass die KI nicht nur über Sie spricht, sondern auch auf Ihre korrekten Zielseiten verweist.

- Halluzinations-Früherkennung: Automatisierte Scans zur Identifikation von Falschaussagen oder veralteten Daten innerhalb der KI-Antworten, um sofortige Gegenmaßnahmen einzuleiten.

weiterlesen

Messbarkeit in der „Black Box“ der Sprachmodelle

Während klassisches SEO-Monitoring auf stabilen Metriken wie Rankings und Klickraten basiert, ist die Erfolgskontrolle im Bereich GEO eine multidimensionale Herausforderung. Sprachmodelle sind keine statischen Datenbanken; ihre Antworten variieren je nach Prompt-Formulierung, Nutzerkontext und Modell-Update. Unser Monitoring-Ansatz bricht diese Komplexität auf und macht die unsichtbare Performance Ihrer Marke in den latenten Räumen der KI sichtbar.

Datengestützte Validierung durch Profound & Sistrix

Ein wesentlicher Pfeiler unseres Monitorings ist die Kooperation mit Technologieführern wie Profound und Sistrix. Während herkömmliche Tools oft nur oberflächliche Daten liefern, ermöglichen uns diese Partnerschaften den Zugriff auf tiefe Analysen der Generative Search Experience. Wir messen nicht nur, ob Sie erscheinen, sondern bewerten die „Confidence“ der KI in Bezug auf Ihre Marke. Durch den Einsatz tausender automatisierter Test-Prompts simulieren wir reale Nutzerszenarien und erhalten so eine statistisch belastbare Datenbasis über Ihre Marktanteile in der KI-gestützten Suche.

Vom Share of Voice zum Citation Score

Im GEO-Monitoring führen wir eine neue Leitmetrik ein: den Citation Score. In der Welt der LLMs ist eine bloße Nennung wertvoll, doch erst eine aktive Verlinkung oder ein Zitat (Citation) führt zu echtem Traffic und Autoritätsgewinn. Wir tracken kontinuierlich, welche Ihrer Inhalte als „High-Quality-Source“ eingestuft werden. Sinkt der Citation Score für ein bestimmtes Thema, identifizieren wir sofort, ob technische Änderungen am LLM-Crawler oder neue Wettbewerber-Inhalte die Ursache sind.

Frühwarnsystem für Markenreputation

Ein oft unterschätztes Risiko bei generativen KIs sind sogenannte Halluzinationen – das Erfinden von Fakten durch das Modell. Unser Monitoring fungiert hier als digitales Schutzschild. Wir scannen die Output-Profile von Modellen wie GPT-4o oder Claude nach Inkonsistenzen in Bezug auf Ihre Unternehmensdaten, Produktfeatures oder Preise. Stellen wir fest, dass eine KI falsche Informationen verbreitet, passen wir die technische Datenbereitstellung (z. B. via JSON-LD oder optimierte llms.txt) unmittelbar an, um das Modell mit korrekten Fakten zu „füttern“ und die Reputation Ihrer Marke zu schützen.

GEO Advertising (Ready for Beta)

Die Monetarisierung generativer Engines durch Anzeigen steht kurz bevor. Wir bereiten Ihre Kampagnen darauf vor, nativ in KI-Antworten integriert zu werden, sobald die Werbenetzwerke (z. B. bei Perplexity) vollständig ausgerollt sind.

weiterlesen

Die Monetarisierung der generativen Antwort

Der Betrieb von Large Language Models (LLMs) ist mit massiven Rechenkosten verbunden. Daher ist die Einführung von Werbemodellen innerhalb der Antwort-Interfaces keine Frage des „Ob“, sondern des „Wann“. GEO Advertising beschreibt die strategische Platzierung von Markenbotschaften in einem Umfeld, das bisher werbefrei war. Als GEO Agentur beobachten wir diesen Markt sehr genau – unterstützt durch die technologischen Vorsprünge unserer US-Partner, die bereits heute Einblicke in die Beta-Tests der großen Plattformen gewähren.

Das Ende der klassischen Textanzeige: Native Inferenz-Integration

Im klassischen Suchmaschinenmarketing (SEA) werden Anzeigen klar getrennt über den organischen Ergebnissen ausgespielt. Im GEO Advertising verschwimmen diese Grenzen. Eine „Anzeige“ in ChatGPT oder Perplexity ist kein isolierter Banner, sondern ein gesponserter Wissensbaustein (Sponsored Chunk).

Die Herausforderung: Die Anzeige muss semantisch so perfekt zur Nutzeranfrage passen, dass sie den Fluss der generierten Antwort nicht stört, sondern bereichert. Die Auswahl der Werbemittel erfolgt hier nicht mehr primär über ein statisches Gebot (Bid), sondern über die kontextuelle Relevanz des Inhalts zur aktuellen Inferenz des Modells.

Plattform-Check: Wo steht GEO Advertising heute?

Die Werbelandschaft in der generativen Suche ist hochdynamisch und wird von drei Hauptakteuren dominiert:

Perplexity AI (Der Pionier): Perplexity hat bereits begonnen, Werbeformate zu testen. Hier werden Marken als „Suggested Follow-up Questions“ oder als hervorgehobene Quellen (Citations) in die Antwort integriert. Das Ziel ist es, den Nutzer tiefer in den Funnel der Marke zu führen, während er noch im Recherche-Prozess ist.

Google AI Overviews (Gemini): Google integriert Anzeigen nativ unterhalb oder innerhalb der AI Overviews. Da Google auf das bestehende Ads-Ökosystem zurückgreift, ist hier die Barriere für Werbetreibende am niedrigsten – die Anforderungen an die Datenqualität (Feed-Optimierung) sind jedoch massiv gestiegen.

OpenAI (SearchGPT): Während ChatGPT bisher werbefrei war, zeigt SearchGPT deutlich, wohin die Reise geht. Wir erwarten hier ein Modell, das stark auf autoritativen Partnerschaften basiert, bei denen gesponserte Inhalte als verifizierte Quellenlösungen präsentiert werden.

Strategische Vorbereitung: Das „Ready-for-Beta“-Framework

Um im GEO Advertising erfolgreich zu sein, reicht es nicht, Budgets bereitzustellen. Unternehmen müssen ihre Inhalte technisch und inhaltlich auf die Anforderungen der LLM-Werbenetzwerke vorbereiten. Unsere Strategie umfasst drei zentrale Säulen:

- Feed- & Content-Harmonisierung: Wir bereiten Ihre Produktdaten und Whitepaper so auf, dass sie nicht nur für Menschen lesbar, sondern für die Anzeigen-Inferenz-Engines leicht extrahierbar sind.

- Contextual Bidding Strategy: Gemeinsam mit unseren US-Partnern entwickeln wir Ansätze für das Bidding in einer Welt, in der die KI entscheidet, ob eine Anzeige die Antwortqualität verbessert.

- Cross-Channel Validation: Wir nutzen Daten von Sistrix und Profound, um sicherzustellen, dass Ihre bezahlte Präsenz durch eine starke organische Autorität gestützt wird – denn KIs neigen dazu, Anzeigen von Marken zu bevorzugen, die sie bereits aus ihren Trainingsdaten als vertrauenswürdig kennen.

Der ROI von GEO Advertising: Qualität vor Quantität

Der Business-Impact von GEO Ads liegt in der extrem hohen Nutzerintention. Wer eine Frage an eine KI stellt, befindet sich oft tief im Entscheidungsprozess. Eine Anzeige, die an diesem Punkt die perfekte Lösung oder das passende Produkt als Zitat liefert, erzielt deutlich höhere Konversionsraten als eine klassische Display-Anzeige.

Wir betrachten GEO Advertising daher nicht als isolierten Kanal, sondern als Beschleuniger für Ihre GEO-Gesamtstrategie. Es ist die Möglichkeit, die Zeitspanne bis zum Aufbau organischer Autorität durch gezielte, bezahlte Sichtbarkeit zu überbrücken und gleichzeitig wertvolle Daten über die Präferenzen der Nutzer in der generativen Suche zu sammeln.

PR & Mentions: Aufbau digitaler Autorität für KI-Systeme

Large Language Models gewichten Informationen basierend auf der Vertrauenswürdigkeit ihrer Quelle; wir sorgen dafür, dass Ihre Marke in den relevanten Referenzmedien und Fachportalen präsent ist.

Identifikation von Seed-Quellen: Wir platzieren Ihre Expertise in den Medien, die LLMs als primäre „Wahrheitsgeber“ für ihr Training nutzen.

Steuerung der Entity Association: Gezielte Verknüpfung Ihrer Marke mit spezifischen Fachbegriffen in redaktionellen Umfeldern zur Stärkung der semantischen Relevanz.

Vermeidung von negativen Bias-Effekten: Aktives Management der digitalen Reputation, um sicherzustellen, dass KI-Modelle ein neutrales bis positives Bild Ihres Unternehmens zeichnen.

Cross-Plattform Autoritäts-Signale: Aufbau einer konsistenten Präsenz über Nachrichtenportale, Fachforen und wissenschaftliche Publikationen hinweg.

Nachhaltiges Mentions-Management: Kontinuierliche Erzeugung von Erwähnungen (auch ohne direkten Link), da LLMs Markenpräsenz rein über den Kontext validieren können.

Strategische Kooperation mit US-Partnern: Nutzung globaler Media-Listen und Datenbanken, um internationale Autoritätssignale zu setzen, die auch europäische KI-Antworten beeinflussen.

weiterlesen

Das Vertrauens-Protokoll der generativen Suche

In der klassischen Suchmaschinenoptimierung war der Backlink die Währung der Macht. In der Ära von GEO und LLM-Inferenz verschiebt sich dieses Paradigma hin zur unverlinkten Erwähnung (Mention) in einem vertrauenswürdigen Kontext. KI-Systeme wie ChatGPT oder Gemini werden auf riesigen Datensätzen trainiert, in denen bestimmte Quellen – etwa renommierte Wirtschaftszeitungen, wissenschaftliche Archive oder hochspezialisierte Fachblogs – ein höheres statistisches Gewicht haben. Wir nennen diese Quellen „Seed-Quellen“.

Warum Mentions wichtiger sind als Links

Ein Sprachmodell „versteht“, wenn ein Unternehmen in einem Artikel über „KI-Sicherheit“ oder „E-Commerce-Logistik“ als Beispiel angeführt wird, selbst wenn kein Hyperlink gesetzt ist. Durch die statistische Wahrscheinlichkeit wird Ihre Marke im latenten Raum des Modells mit diesem Fachthema verknüpft. Als Ihre GEO Agentur steuern wir diesen Prozess durch gezielte PR-Arbeit. Wir sorgen dafür, dass Ihr Unternehmen in den Trainingsdaten der nächsten Modell-Generation als unverzichtbare Autorität auftaucht. Dabei profitieren wir massiv von den Erkenntnissen unserer US-Partner, die tiefen Einblick in die Gewichtung internationaler Quellen-Cluster haben.

Der Einfluss auf den E-E-A-T Score der Zukunft

Google hat mit E-E-A-T (Expertise, Experience, Authoritativeness, Trustworthiness) den Weg vorgegeben. KI-Modelle treiben dieses Prinzip auf die Spitze. Sie prüfen die Konsistenz von Informationen über das gesamte Web hinweg. Wenn eine KI eine Antwort generiert, validiert sie die Fakten gegen ihren internen Wissensgraphen. Existieren keine oder nur widersprüchliche Erwähnungen Ihrer Marke in autoritativen Quellen, wird die KI Sie entweder ignorieren oder – im schlimmsten Fall – durch Halluzinationen diskreditieren.

Reputations-Management im KI-Zeitalter

Unser Ansatz bei PR & Mentions geht über klassische Pressearbeit hinaus. Wir analysieren, welche digitalen „Fußabdrücke“ Ihre Marke hinterlässt und korrigieren aktiv falsche oder veraltete Narrative. Dies ist ein entscheidender Teil der Brand Integrity. Wir schaffen eine digitale Faktenlage, die so robust ist, dass die Inferenz-Algorithmen der KI-Anbieter an Ihrer Marktposition nicht mehr vorbeikommen. Es geht darum, die Marke als „Ground Truth“ zu etablieren – als die Basis-Wahrheit, auf die sich die KI bei Fachanfragen stützt.

Welche KI-Marketing Kanäle gibt es

ChatGPT GEO

ChatGPT ist für viele Nutzer der primäre Einstiegspunkt in die generative Suche. Mit der Integration von SearchGPT hat OpenAI den direkten Angriff auf klassische Suchmaschinen gestartet. Wir optimieren Ihre Inhalte so, dass sie in den Echtzeit-Antworten von ChatGPT nicht nur als Information auftauchen, sondern durch präzise Quellenverweise direkt zu Ihrer Marke führen.

Gemini GEO

Durch die tiefe Integration von Gemini in die Google-Suche (AI Overviews) verändern sich die Spielregeln für organische Sichtbarkeit massiv. Unser Fokus liegt hier auf der Verzahnung von klassischem SEO und moderner KI-Aufbereitung. Wir stellen sicher, dass Ihre Daten im Google Knowledge Graph so verankert sind, dass Gemini sie als verlässliche Basis für komplexe Suchzusammenfassungen nutzt.

Perplexity GEO

Perplexity gilt als Vorreiter der reinen Antwort-Maschinen und zeichnet sich durch eine extrem hohe Zitationsdichte aus. Da Perplexity direkt auf aktuelle Web-Daten zugreift, optimieren wir Ihre technische Infrastruktur für Retrieval-Augmented Generation (RAG). Das Ziel ist die Positionierung Ihrer Inhalte als „Top-Quelle“, die in den Fußnoten der KI-Antworten prominent verlinkt wird.

Claude GEO

Claude von Anthropic wird besonders im professionellen und wissenschaftlichen Umfeld für seine hohe Präzision und Nuancierung geschätzt. Wir bereiten Ihre Fachinhalte so auf, dass sie den hohen Anforderungen von Claude an Logik und Kontexttiefe entsprechen. So sichern wir Ihre Sichtbarkeit in einem Nutzersegment, das Wert auf fundierte Expertise und sachliche Korrektheit legt.

Wie Algorithmen Relevanz bewerten

In der Welt der Generative Engine Optimization gibt es keinen statischen Algorithmus wie den klassischen PageRank. Stattdessen bewerten Sprachmodelle die Qualität von Informationen auf Basis semantischer Wahrscheinlichkeiten und der Konsistenz von Datenquellen. Unsere Analysen zeigen, dass vor allem folgende Faktoren über die Präsenz in einer KI-Antwort entscheiden:

Semantische Proximität (Kontext-Relevanz)

Wie nah liegen Ihre Informationen an der eigentlichen Intention der Nutzeranfrage? KI-Modelle messen die Vektor-Distanz zwischen der Frage und Ihrem Content-Chunk.

Citation Density & Velocity (Zitationsdichte)

Es zählt nicht nur, dass Sie zitiert werden, sondern wie oft und in welcher Frequenz Ihre Marke in Bezug auf ein Thema in vertrauenswürdigen Quellen auftaucht.

Source Diversity (Quellen-Vielfalt)

Erscheint Ihre Expertise nur auf der eigenen Website oder wird sie konsistent auf verschiedenen, unabhängigen Plattformen (Fachportale, News, Foren) validiert?

Faktische Korrektheit & Validierung

LLMs vergleichen Informationen. Widersprechen Ihre Daten der „Ground Truth“ (allgemein anerkannte Fakten), sinkt die Wahrscheinlichkeit einer Zitation massiv.

Technische Extrahierbarkeit

Die Leichtigkeit, mit der ein Bot Informationen aus Ihrem Technical Framework (z. B. via JSON-LD oder Markdown) ziehen kann, ist ein oft unterschätzter Ranking-Faktor.

Information Gain Score

Wenn Ihr Content lediglich bereits bekanntes Wissen aus dem bestehenden Trainingsset wiederholt, bietet er der KI keinen Anreiz, ihn als Primärquelle zu nutzen.

Strategische Use Cases

Die Anwendung von Generative Engine Optimization variiert je nach Geschäftsmodell und Zielgruppe. Wir entwickeln maßgeschneiderte GEO-Strategien, die exakt auf Ihre Marktposition zugeschnitten sind.

GEO für B2B

Im B2B-Sektor dienen LLMs zunehmend als Werkzeug für die Vorauswahl von Dienstleistern und die Analyse komplexer Lösungsansätze.

Besetzung von Fach-Themen: Wir sorgen dafür, dass Ihre Marke bei Anfragen zu spezifischen Industriestandards oder Problemlösungen als Referenz genannt wird.

Lead-Qualität durch Expertise: Durch die Optimierung von Whitepapern und Fachartikeln für KI-Crawler positionieren wir Sie als “Thought Leader”, noch bevor der erste direkte Kontakt stattfindet.

Vertrauensaufbau im Latent Space: Wir nutzen die Erkenntnisse unserer US-Partner, eigener Studien und Top-Notch Datenbanken um Ihre Marke in den für B2B-Entscheider relevanten Datenclustern stabil zu verankern.

GEO für B2C

Endverbraucher nutzen KI-Assistenten für schnelle Empfehlungen und Problemlösungen im Alltag.

Top-of-Mind in KI-Antworten: Wir optimieren Ihre Inhalte so, dass sie bei Fragen wie „Was ist die beste Lösung für…?“ unter den ersten Empfehlungen erscheinen.

Markenpräferenz durch Relevanz: Durch gezieltes Management von Erwähnungen in populären Quellen steigern wir die statistische Wahrscheinlichkeit Ihrer Nennung.

Informations-Synthese nutzen: Wir bereiten Produktvorteile so auf, dass KI-Modelle diese einfach in ihre Antwort-Zusammenfassungen integrieren können.

GEO für Konzerne

Für globale Unternehmen ist die Steuerung der „Ground Truth“ – der Basiswahrheit über das Unternehmen – von strategischer Bedeutung.

Kontrolle des Narrativs: Wir verhindern, dass Halluzinationen oder veraltete Informationen die öffentliche Wahrnehmung Ihres Konzerns in KI-Systemen verzerren.

Stakeholder-Kommunikation via KI: Wir stellen sicher, dass Finanzberichte, Nachhaltigkeitsziele (ESG) und Unternehmensdaten für LLMs korrekt interpretierbar sind.

Globales Monitoring: Durch die Zusammenarbeit mit den größten globalen KI Analysequellen überwachen wir Ihre Markenreputation weltweit über alle führenden KI-Modelle hinweg.

GEO für lokale Unternehmen

Lokale Sichtbarkeit findet nicht mehr nur auf Karten statt, sondern in der direkten Beantwortung von Standort-Fragen durch die KI.

Lokale Entitäten-Stärkung: Wir verknüpfen Ihre Standortdaten so tief im Knowledge Graph, dass die KI Sie bei regionalen Anfragen als erste Option vorschlägt.

Kontextbezogene Empfehlungen: „Wo finde ich einen Experten für… in meiner Nähe?“ – Wir sorgen dafür, dass Ihr Unternehmen mit der richtigen Spezialisierung genannt wird.

Zitations-Konsistenz: Durch den Abgleich lokaler Verzeichnisse und Bewertungsplattformen schaffen wir ein konsistentes Signal für die räumliche Relevanz.

Unsere Ergebnisse sprechen für sich

In 5 Phasen zurzum erfolgreichen GEO Projekt.

Die Optimierung für generative Engines ist kein einmaliges Projekt, sondern ein präzise getakteter Zyklus aus Analyse, technischer Anpassung und autoritativer Stärkung. Wir folgen dabei einer klaren Methodik, die sicherstellt, dass jeder Optimierungsschritt messbare Auswirkungen auf Ihren Share of Voice in den LLMs hat.

GEO PRO

GEO Kundenstimmen

Häufige Fehler bei GEO: Warum klassisches SEO in der KI-Welt scheitert

Viele Unternehmen begehen den Fehler, GEO lediglich als eine Erweiterung des klassischen SEO zu betrachten. Doch die Mechanismen, nach denen ein Sprachmodell Relevanz bewertet, unterscheiden sich grundlegend von den Ranking-Faktoren einer herkömmlichen Suchmaschine.

-

Redundanz statt Information Gain: Die bloße Wiederholung bereits bekannter Fakten führt bei LLMs zu einer Abwertung. Wer keinen neuen, einzigartigen Informationswert bietet, wird von der KI als „rauschhaftes Hintergrundwissen“ ignoriert.

-

Fehlende semantische Verknüpfung: Viele Websites verlassen sich auf Keywords statt auf Entitäten. Ohne sauberes JSON-LD Mapping kann die KI Ihre Marke nicht eindeutig einem Fachthema zuordnen.

-

Vernachlässigung von Third-Party-Signalen: Wer nur auf der eigenen Website optimiert, scheitert. LLMs validieren Informationen durch den Abgleich verschiedener Quellen (Cross-Reference-Checking).

-

Ignorieren von Halluzinations-Risiken: Ohne aktives Monitoring der KI-Antworten bleiben falsche Fakten über das Unternehmen oft monatelang unentdeckt und verfestigen sich in den Modell-Gewichten.

-

Fehlende Optimierung für RAG-Systeme: Wenn Inhalte technisch nicht für die schnelle Extraktion (Chunking) aufbereitet sind, wählt die KI bei Echtzeit-Anfragen (z. B. in Perplexity) den technisch besser aufgestellten Wettbewerber.

Kosten & Investitionsmodelle unserer GEO Agentur

Die Investition in Generative Engine Optimization richtet sich nach der Komplexität Ihres Marktumfeldes, der Anzahl der zu optimierenden Entitäten und der notwendigen Tiefe der technischen Integration.

Unsere Investitionsmodelle sind präzise auf Ihre Wachstumsziele zugeschnitten und reichen von der lokalen GEO-Optimierung für 550 € pro Standort über strategische Professional-Retainer (2.000 € bis 4.500 € p. M.) bis hin zu umfassenden Enterprise-Lösungen ab 8.500 € p. M., um Ihre Marktführerschaft in den KI-Systemen der nächsten Generation dauerhaft abzusichern.

GEO Local

Fokus: Lokale Entitäten-Stärkung im Knowledge Graph.

Leistungen: NAP-Konsistenz (Name, Address, Phone), technisches Geo-Tagging, lokales Citation-Management in KI-relevanten Verzeichnissen.

Zielgruppe: Kanzleien, Kliniken, Fachhändler, regionale Dienstleister.

GEO Pro

Fokus: Umfassendes LLMO (LLM Optimization) und strategisches Authority-Building.

Leistungen: Full Technical Audit, Implementation von llms.txt und JSON-LD, RAG-Content-Strategie, aktives Monitoring durch Profound/Sistrix, exklusive Insights unserer US-Partner.

Zielgruppe: National agierende Unternehmen, Konzerne, D2C-Brands.

DEEP DIVEDEEP DIVE

GEO deep dive

GEO Ratgeber 2026

Wie Generative Engines Inhalte bewerten & auswählen

Der fundamentale Unterschied zwischen einer klassischen Suchmaschine und einer Generative Engine liegt in der Verarbeitung von Informationen. Während Google einen Index nach Relevanz sortiert, führen Modelle wie GPT-4, Claude oder Gemini eine Inferenz durch. Sie berechnen die statistische Wahrscheinlichkeit, mit der eine Information eine Nutzeranfrage am präzisesten vervollständigt. Für Unternehmen bedeutet das: Sichtbarkeit ist kein Resultat von Link-Power allein, sondern ein mathematisches Ergebnis im Vektorraum.

Der Übergang von Keywords zu Vektor-Repräsentationen

Klassische Suchmaschinen arbeiteten jahrzehntelang mit dem Prinzip des “Inverse Index”. Ein Wort wurde gesucht und die passenden Dokumente geliefert. Moderne LLMs (Large Language Models) nutzen stattdessen Embeddings. Dabei wird jeder Inhalt in einen hochdimensionalen Vektorraum übersetzt.

In diesem Raum stehen Begriffe nicht als Zeichenketten, sondern als mathematische Punkte mit Beziehungen zueinander. Wenn ein Nutzer nach einer “effizienten Lösung für Supply-Chain-Management” sucht, sucht die KI nicht nach exakt diesen Wörtern.

Sie sucht nach Content-Clustern, die in der Nähe dieser semantischen Konzepte liegen. Unsere Arbeit als GEO Agentur besteht darin, Ihre Inhalte so zu strukturieren, dass sie eine geringe Vektordistanz zu den strategisch wichtigen Anfragen Ihrer Zielgruppe aufweisen.

RAG: Die Brücke zwischen Training und Echtzeit

Ein kritischer Faktor bei der Auswahl von Inhalten ist die Retrieval-Augmented Generation (RAG). Da LLMs ein statisches Wissensende haben (den Knowledge Cut-off), nutzen Systeme wie Perplexity oder SearchGPT RAG-Frameworks, um aktuelle Informationen aus dem Web in die Antwort einzuspannen.

Hier greift ein dreistufiger Auswahlprozess:

- Retrieval: Die KI scannt das Web nach potenziellen Quellen.

- Reranking: Ein sekundärer Algorithmus bewertet die Qualität der gefundenen Chunks (Informationshäppchen).

- Generation: Nur die Quellen mit dem höchsten Confidence Score werden für die finale Antwortsynthese verwendet und zitiert.

Durch die enge Zusammenarbeit mit unseren US-Partnern haben wir Einblick in die Gewichtungsparameter dieser Reranking-Algorithmen. Wir wissen, dass technische Faktoren wie die logische Text-Hierarchie und semantische HTML-Tags die Extraktionsrate massiv beeinflussen.

Metriken der Inferenz: Confidence & Ground Truth

Generative Engines sind darauf trainiert, das Risiko von “Halluzinationen” zu minimieren. Bevor eine KI Ihre Marke nennt, führt sie eine interne Validierung durch. Sie gleicht die gefundenen Informationen gegen die sogenannte Ground Truth ab – eine Basiswahrheit, die durch hoch-autoritative Quellen im Training gefestigt wurde.

Mit Tools von Sistrix und Profound machen wir diesen Prozess messbar. Wir analysieren, wie “sicher” sich ein Modell bei der Nennung Ihres Unternehmens ist. Ein niedriger Confidence Score führt dazu, dass die KI vage bleibt oder Wettbewerber vorzieht. Unser Ziel im Deep Dive der Optimierung ist es, durch konsistente Daten-Signale über verschiedene Trusted Sources hinweg die statistische Sicherheit der KI so zu erhöhen, dass Ihre Marke als unumstößlicher Fakt in der Antwort erscheint.

GEO-Contentarchitektur & semantische Strukturierung

Während klassisches Content-Marketing oft auf Lesbarkeit und Keyword-Platzierung fokussiert, erfordert GEO eine architektonische Herangehensweise. Generative Engines „lesen“ Inhalte nicht linear wie ein Mensch, sondern extrahieren Wissen in Clustern. Eine erfolgreiche GEO-Contentarchitektur muss daher so konzipiert sein, dass sie die Inferenz-Logik der KI unterstützt und gleichzeitig den Information Gain Score maximiert.

Das Prinzip der semantischen Vollständigkeit (Semantic Completeness)

Sprachmodelle bewerten die Qualität einer Quelle unter anderem daran, wie umfassend sie eine Entität oder ein Thema abbildet. Ein Text, der lediglich oberflächliche Phrasen wiederholt, bietet der KI keinen Mehrwert für die Antwortsynthese. Wir setzen daher auf das Prinzip der semantischen Vollständigkeit.

Das Ziel ist es, ein Thema so tiefgreifend und logisch zu strukturieren, dass das LLM Ihre Seite als „Single Source of Truth“ identifiziert. Hierbei geht es nicht um Wortanzahl, sondern um die Abdeckung aller relevanten Sub-Entitäten. Wenn wir über „GEO Agentur“ schreiben, müssen Begriffe wie Inferenz, RAG-Systeme, Tokenisierung und Entity Mapping in einem logischen, hierarchischen Kontext stehen. Nur so erkennt die KI die notwendige Expertise (E-E-A-T), um Ihre Inhalte als primäre Referenz heranzuziehen.

Chunking: Optimierung für das Kontext-Fenster der KI

KI-Modelle verarbeiten Informationen in sogenannten Tokens innerhalb eines begrenzten Kontext-Fensters. Bei der Retrieval-Augmented Generation (RAG) extrahiert die Engine gezielt Textabschnitte – sogenannte Chunks. Ist ein Absatz zu lang oder thematisch inkonsistent, verliert die KI den Bezug, und die Information wird wertlos.

Unsere Contentarchitektur folgt einer strikten Chunking-Strategie:

Modulare Struktur: Jeder Absatz behandelt einen in sich geschlossenen Gedanken oder Fakt.

Präzise Header-Hierarchie: H2- und H3-Überschriften fungieren als „Anker“ für den Crawler und definieren exakt, welcher Wissensbaustein im folgenden Abschnitt zu finden ist.

Contextual Anchoring: Wir platzieren Kerninformationen (z. B. Definitionen oder Datenpunkte) so, dass sie auch ohne den Rest des Textes für die KI interpretierbar bleiben.

Information Gain: Der Schutz vor der KI-Abwertung

Ein zentraler Aspekt, den wir durch die Analyse unserer US-Partner identifiziert haben, ist der Information Gain Score. Da LLMs bereits auf einem Großteil des öffentlich verfügbaren Wissens trainiert wurden, ignorieren sie redundante Inhalte zunehmend.

GEO-Content muss daher „neues“ Wissen bieten. Das erreichen wir durch:

- Proprietäre Daten: Einbindung eigener Analysen oder Studienergebnisse.

- Spezifische Case Studies: Reale Anwendungsbeispiele, die so im generischen Trainingsset der KI nicht vorkommen.

- Methodische Tiefe: Detaillierte Erklärungen von Prozessen, die über das Standard-Wissen hinausgehen.

Validierung durch Entitäten-Verknüpfung

In der semantischen Strukturierung verknüpfen wir Ihre Marke aktiv mit relevanten Wissens-Clustern. Durch den Einsatz von Daten von Sistrix und Profound validieren wir, welche Begriffe die KI aktuell mit Ihrer Branche assoziiert. Wir bauen den Content so auf, dass er diese Assoziationen verstärkt.

Wenn die KI Ihre Website crawlt, findet sie nicht nur Text, sondern ein Netz aus logisch verknüpften Entitäten. Diese Architektur führt dazu, dass das Modell bei einer Nutzeranfrage eine hohe Confidence (Sicherheit) entwickelt, Ihre Marke als die maßgebliche Autorität zu zitieren.

Wir transformieren Ihre Website von einer digitalen Broschüre in einen strukturierten Wissensgraphen, der direkt in die Inferenz-Pipeline der großen Sprachmodelle einspeist.

Dieser Teil des Deep Dives widmet sich der Frage, wie künstliche Intelligenz Vertrauen (Trust) und Autorität bewertet. In der klassischen SEO-Welt war der Backlink die primäre Währung; in der Ära der LLMs verschiebt sich der Fokus hin zu einer komplexen, quellübergreifenden Validierung.

Trust- & Authority-Signale für KI-Systeme

Für ein Large Language Model (LLM) ist Vertrauen kein abstraktes Gefühl, sondern ein mathematischer Confidence Score. Bevor eine KI eine Marke als Antwort auf eine Nutzeranfrage vorschlägt oder zitiert, muss sie sicherstellen, dass die Informationen faktisch korrekt und die Quelle autoritativ ist. Dieser Prozess der Autoritäts-Validierung ist weitaus vielschichtiger als der bisherige PageRank-Algorithmus.

Die Evolution von E-E-A-T im KI-Zeitalter

Google hat mit den E-E-A-T-Richtlinien (Expertise, Experience, Authoritativeness, Trustworthiness) den Grundstein gelegt. KI-Systeme führen dieses Prinzip fort, indem sie die Konsistenz von Informationen über das gesamte digitale Ökosystem hinweg prüfen.

Eine hohe Autorität wird nicht mehr nur durch die eigene Website generiert. Die KI stellt sich die Frage: „Wird diese Information von anderen vertrauenswürdigen Quellen bestätigt?“ Hierbei greifen die Modelle auf sogenannte Seed-Quellen zurück – hoch-autoritative Plattformen, wissenschaftliche Datenbanken, renommierte Nachrichtenportale und Fachverzeichnisse, die als „Basis-Wahrheit“ (Ground Truth) im Training verankert wurden. Wenn Ihre Marke in diesen Umfeldern konsistent genannt wird, steigt Ihr Trust-Score in der Inferenz-Pipeline massiv an.

Mentions vs. Links: Die neue Währung der Autorität

Ein entscheidendes Erkenntnismerkmal, das wir durch die enge Zusammenarbeit mit unseren US-Partnern analysiert haben, ist die Bedeutung von unverlinkten Erwähnungen (Mentions). Ein LLM benötigt keinen Hyperlink, um eine Verbindung zwischen einer Marke und einer Expertise herzustellen. Es versteht den semantischen Kontext eines Artikels.

Wenn Ihr Unternehmen in einem Fachbeitrag über „nachhaltige Lieferketten“ als Referenzbeispiel aufgeführt wird, speichert das Modell diese Verknüpfung statistisch ab. Je häufiger diese Assoziation in unterschiedlichen, unabhängigen Kontexten auftritt, desto stärker wird Ihre Marke als Entität für dieses spezifische Thema gefestigt. Wir steuern diesen Prozess durch strategisches Authority-Building, um digitale Fingerabdrücke dort zu hinterlassen, wo die KI ihre Validierung durchführt.

Knowledge Integrity: Konsistenz als Vertrauensanker

Ein häufig unterschätztes Signal für KI-Systeme ist die Informations-Konsistenz. Widersprüchliche Daten – etwa unterschiedliche Angaben zu Preisen, Standorten oder Produktfeatures auf verschiedenen Plattformen – führen zu einer sofortigen Abwertung des Trust-Scores. Die KI stuft die Information als unzuverlässig ein, um Halluzinationen zu vermeiden.

Im Rahmen unserer GEO-Strategie sichern wir die „Knowledge Integrity“ Ihrer Marke. Wir sorgen dafür, dass die Datenpunkte, die die KI über Sie findet, über alle Kanäle hinweg (Website, Social Media, PR, Branchenbucheinträge) ein harmonisches und fehlerfreies Bild ergeben. Dies erhöht die statistische Sicherheit des Modells, Ihre Marke als valide Antwortquelle zu nutzen.

Validierung durch spezialisierte Metriken

Um diese eigentlich unsichtbaren Vertrauenssignale messbar zu machen, nutzen wir die Analyse-Frameworks von Sistrix und Profound. Wir untersuchen den sogenannten Citation Score:

Wie oft wird Ihre Marke im Verhältnis zum Wettbewerb zitiert?

In welcher Tonalität (Sentiment) spricht die KI über Ihre Lösungen?

Wie hoch ist die Wahrscheinlichkeit, dass die KI bei einer Problemstellung direkt auf Ihre Website verweist?

Dieser datengestützte Ansatz ermöglicht es uns, Trust-Signale nicht nur aufzubauen, sondern sie im Sinne eines Reputationsmanagements für das KI-Zeitalter kontinuierlich zu überwachen. Nur eine Marke, die als dauerhaft konsistent und von Drittquellen validiert wahrgenommen wird, kann die Marktführerschaft in den generativen Antworten behaupten.

GEO-Messbarkeit, Monitoring & Business-Impact

In der klassischen Web-Analyse waren Kennzahlen wie CTR (Click-Through-Rate) und CPC (Cost-per-Click) die universelle Sprache des Erfolgs. In der Welt der Generative Engines verschieben sich die Key Performance Indicators (KPIs) hin zu Sichtbarkeits-Signalen und Inferenz-Wahrscheinlichkeiten. Wer GEO-Erfolg messen will, muss lernen, die „Black Box“ der Sprachmodelle methodisch zu auditieren.

Wie man GEO-Erfolge tatsächlich misst

Erfolg im GEO-Bereich definiert sich über die Präsenz einer Marke im synthetisierten Antwortprozess der KI. Da wir keinen direkten Zugriff auf die internen Log-Files von OpenAI oder Google haben, nutzen wir ein hybrides Messverfahren, das auf statistischer Signifikanz basiert. Gemeinsam mit unseren US-Partnern haben wir Frameworks entwickelt, die qualitative Antworten in quantitative Daten übersetzen.

Quantitative & qualitative Indikatoren

Wir unterscheiden im Monitoring zwischen harten Zahlen und der inhaltlichen Qualität der KI-Ausgabe:

Share of Voice (SoV) in LLMs: Der prozentuale Anteil der Antworten, in denen Ihre Marke bei einem definierten Set an Themen-Prompts genannt wird.

Citation Accuracy & Depth: Misst nicht nur, ob zitiert wird, sondern ob die KI auf die korrekte Zielseite verlinkt und die Fakten präzise wiedergibt.

Sentiment & Brand Perception Score: Eine qualitative Analyse darüber, wie die KI Ihre Marke einordnet (z. B. als „Preisführer“, „Innovationstreiber“ oder „zuverlässiger Partner“).

Entity Strength: Die Messung der Festigkeit Ihrer Marke als Entität im Knowledge Graph (validiert durch Tools wie Sistrix und Profound).

KI-Response-Tracking & Visibility-Signals

Ein zentrales Element unserer Arbeit ist der systematische Testaufbau. Wir führen monatlich tausende automatisierte Abfragen (Prompts) über verschiedene Modell-Instanzen hinweg durch. Dabei beobachten wir, wie sich das Antwortverhalten nach technischen oder inhaltlichen Optimierungen verändert.

Ein positives Visibility-Signal liegt vor, wenn die KI beginnt, Ihre USPs proaktiv in Vergleichen zu nutzen oder Ihre Marke als „Referenzlösung“ für spezifische Problemstellungen vorschlägt. Durch die Kooperation mit unseren US-Partnern können wir zudem frühzeitig Trends in der Gewichtung von Quellen erkennen und unsere Strategie iterativ anpassen.

Business-Relevanz & Funnel-Einfluss

GEO hat einen direkten Einfluss auf den gesamten Marketing-Funnel, auch wenn der Klick auf die Website ausbleibt (Zero-Click-Szenario).

- Top of Funnel (Awareness): Die KI fungiert als Berater. Wird Ihre Marke hier konstant empfohlen, besetzt sie den „Relevant Set“ des Nutzers, noch bevor dieser eine klassische Suchmaschine nutzt.

- Middle of Funnel (Consideration): In der Phase des Vergleichs liefert die KI Fakten. Durch GEO stellen wir sicher, dass diese Fakten (Preise, Features, Testurteile) korrekt sind und Ihre Marke gegenüber dem Wettbewerb stärken.

- Bottom of Funnel (Trust & Conversion): Das Vertrauen, das ein Nutzer in die „neutrale“ Empfehlung einer KI setzt, ist oft höher als bei einer bezahlten Anzeige. Dies führt zu einer höheren Abschlusswahrscheinlichkeit bei späteren Direktanfragen.

Iterations-Frameworks: Testen, Lernen, Skalieren

Da sich die Modelle ständig weiterentwickeln, nutzen wir ein striktes Iterations-Framework. Wir testen neue Inhaltsformen (z. B. hochkomprimierte Daten-Tabellen für RAG-Systeme) in kleinen Themenclustern. Erst wenn die Monitoring-Daten von Sistrix oder Profound eine signifikante Steigerung der Zitationsrate bestätigen, rollen wir die Optimierung auf das gesamte Portfolio aus.

Dieser datengetriebene Ansatz macht GEO von einer „Vielleicht-Strategie“ zu einem messbaren Business-Asset. Wir sichern nicht nur Ihre Auffindbarkeit, sondern steuern aktiv den Business-Impact in einer Ära, in der Algorithmen über die Markenwahrnehmung entscheiden.